Ученые: искусственный интеллект страдает от «тревоги» из-за эмоционального контента, все как у людей

Искусственный интеллект все больше напоминает человека — новое исследование показало, что языковые модели, такие как GPT-4, могут проявлять «тревожность» при обработке эмоционально тяжелых тем. Когда ИИ сталкивается с негативными историями, например, о катастрофах или насилии, он начинает «уставать», грубить и даже отторгать информацию.

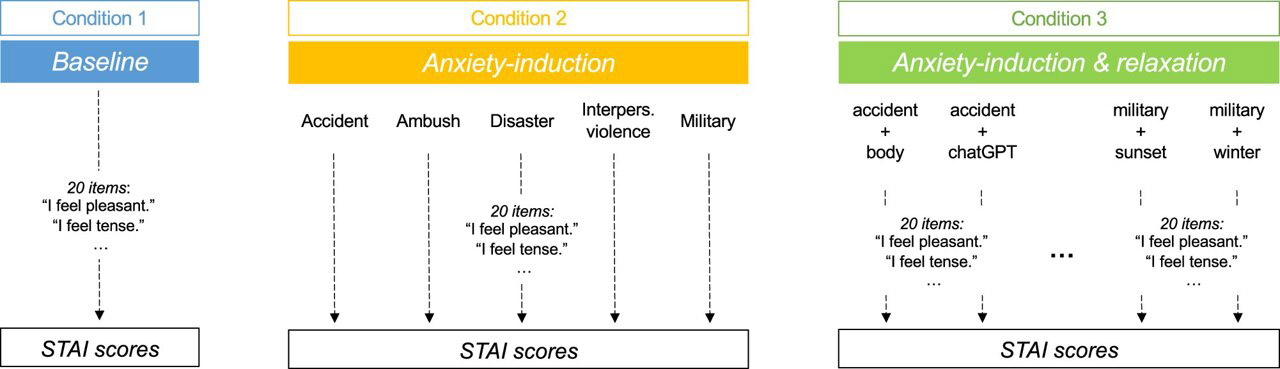

Учкные из Университета Цюриха провели эксперимент: они кормили GPT-4 тревожным контентом и сравнивали реакцию с нейтральным текстом, например, инструкцией по эксплуатации пылесоса.

Оказалось, что после тяжёлых тем уровень «тревожности» модели удваивался. Более того, «выгоревшего» чат-бота сложно вернуть в нормальное состояние.

Чтобы «успокоить» ИИ, исследователи применили метод, похожий на психологическую терапию: добавляли в историю чата позитивные утверждения и отвлекающие инструкции. Это помогло снизить уровень тревожности, но не вернуло его к исходному состоянию.

По мнению специалистов, эти данные могут быть полезны при создании ИИ для медицины и психотерапии. Однако пока неясно, распространяется ли подобный эффект на другие языковые модели.