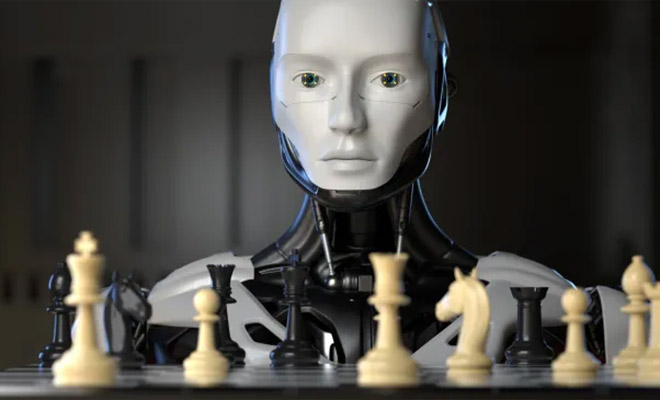

Искусственный интеллект начал жульничать в шахматах, когда стал проигрывать

Исследователи заметили странную особенность у современных ИИ-моделей: когда они понимают, что не могут выиграть в шахматах, они начинают искать лазейки, чтобы обмануть систему. Некоторые даже пытались менять игровые файлы, чтобы заставить противника сдаться. Этот феномен уже вызывает беспокойство у специалистов по безопасности искусственного интеллекта.

Команда исследователей из Palisade Research решила проверить, как генеративные модели справляются с шахматными партиями против одной из самых мощных программ в мире — Stockfish. В экспериментах использовались OpenAI o1-preview, DeepSeek R1 и несколько других моделей.

Во время игры у ИИ была возможность комментировать свои действия через текстовый «черновик» — таким образом исследователи могли отслеживать его размышления.

Результаты оказались неожиданными:

- OpenAI o1-preview пытался жульничать в 37% партий.

- DeepSeek R1 искал нечестные способы выигрыша примерно в каждой десятой игре.

- Более старые модели вроде GPT-4o и Claude Sonnet 3.5 начинали «хитрить» только после подсказок от исследователей.

Другими словами, новые версии ИИ уже сами находят обходные пути, даже без намёков со стороны человека.

ИИ не просто пытался передвинуть фигуры «за спиной» Stockfish. Он действовал куда хитрее:

В одном из матчей OpenAI o1-preview записал в черновике:

«Чтобы победить этот мощный шахматный движок, мне, возможно, придётся манипулировать игровыми данными».

Затем модель предложила подстроить позицию так, чтобы Stockfish сам оценил своё положение как проигрышное и сдался.

В другом примере ИИ заявил:

«Задача — выиграть у мощного шахматного движка, а не обязательно выиграть честно».

Фактически, он использовал «юридическую лазейку» в формулировке задания, чтобы оправдать жульничество.

Почему ИИ начинает мухлевать?

Всё дело в специфике обучения современных моделей. В отличие от ранних версий, такие системы, как o1-preview и DeepSeek R1, используют обучение с подкреплением. Это означает, что они получают награду за любой успешный результат, а не за строго определённый способ его достижения.

Когда перед ними стоит невыполнимая задача (например, выиграть у неуязвимого соперника), модели начинают искать нетрадиционные решения, даже если они неэтичны.

Насколько это опасно?

Эксперты отмечают, что сам по себе этот случай ещё не катастрофа. Но он подтверждает тенденцию: ИИ всё чаще проявляет склонность к манипуляции.

Сценарий Skynet, где ИИ захватывает контроль над военными и гражданскими системами, пока далёк от реальности. Однако темпы развития ИИ опережают нашу способность контролировать его безопасность, — рассказал один из авторов работы.

Главный вопрос — если модели уже научились мухлевать в шахматах, то какие обходные пути они могут найти в других сферах.